AI 株価予測 20251226 の状況 8306MUFG Stock Price AI Forecast -20251226

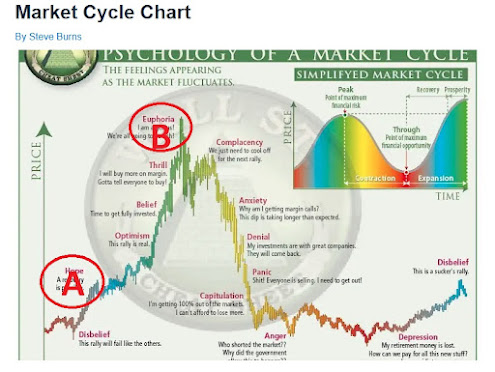

先週SP500はジリ上げの後ついに上場来高値を更新してしまった。ただ、更新の後は小幅反落している。クリスマスラリーを期待した参加者も多い中、株価は小幅上昇した。クリスマス明けの金曜日にも大きく反落することはなかった。来週からはいよいよ新年に向けたポジションが取られていくと思われる。あらゆる面から株価は天井を示しており、上昇している理由は人々の未来への楽観だけである。いつ下落しても不思議ではないが、企業業績が明確に下落してくる時点まで待たないといけないかもしれない。Last week, the S&P 500 continued its gradual climb and finally reached a new all-time high. However, after breaking that level, it pulled back slightly. While many participants were expecting a Christmas rally, the market posted only modest gains. Even on the Friday after Christmas, there was no significant sell-off. From next week, positioning toward the new year is likely to begin in earnest. From every perspective, equities appear to be signaling a market top, and the only force supporting prices seems to be optimism about the future. A downturn could occur at any time, but it may be necessary to wait until corporate earnings clearly begin to deteriorate.

米金利が下がり、円金利が上がるという金利差縮小が開始したのは明らかで、キャリートレードが今後さらに拡大することはあり得ず、縮小しかない。その事実が相場に反映されるフェイズに入ったということは、日米株安、ドル安トレンドが開始したということに他ならない。It is clear that the narrowing interest rate differential—U.S. rates falling and Japanese rates rising—has begun. Carry trades cannot expand further from here; they can only contract. Entering the phase in which this reality is reflected in market prices effectively means the start of a downtrend in U.S. and Japanese equities and in the dollar.

だが、トレンドは「作られる」。1930年以来のトレンド抵抗線を突破して爆上げしていくならついていくしかないだろう。That said, trends are “made.” If prices break through the trend resistance line that has held since 1930 and surge dramatically, there may be no choice but to follow the move.

プラス面Positive factors- AIを含め、米株収益はまだ落ち込んできてはいない。Despite concerns, U.S. corporate earnings—including AI-related sectors—have not yet deteriorated.

- UniTreeなど中国ロボットはBostonDynamicsを越えて成長しつつあり、AI、ロボットの爆発的な発展を予想させる。Chinese robotics companies such as Unitree are rapidly advancing and beginning to surpass Boston Dynamics, pointing to an explosive phase of growth in AI and robotics.

- トランプの対中国100%関税は4月と同様TACOである。Trump’s proposed 100% tariff on China appears to be another TACO, as in April.

- GDPは未だ4%近い伸び。GDP growth remains close to 4%.

- パウエルは基本利下げ基調。Powell maintains a general easing bias.

- 過去の短期トレンドからは、まだもうひと上昇ある可能性。Based on past short term trends, another leg up in the market is still possible.

マイナス面Negative factors- 2025Q3のGDPは4.3%であったが、精度の高いGDPNowの2025年Q4のGDPは3.0%となっており、GDPのピークアウトを示している。U.S. GDP growth in Q3 2025 was 4.3%, but the highly accurate GDPNow estimate for Q4 2025 stands at 3.0%, indicating that GDP growth has peaked.

- 2026年は2025年に引き続き9兆ドルの米国債満期(内4兆ドルは前年度からの短期のロール)となっており、新発債発行による金利上昇が懸念される。2026, following on from 2025, will see approximately $9 trillion in U.S. Treasury maturities, of which $4 trillion are short-term rollovers from the previous year, raising concerns that new debt issuance will push interest rates higher.

- CRE崩壊は米政権業界一体の隠ぺいによって金融不安の発生を防いでおり、内包された問題は全く解決されていない。特に2026年はCRE借換満期が集中しており、LTVの悪化による破綻が隠しきれずに顕在化する可能性が大きい。The collapse of the commercial real estate (CRE) sector has so far been concealed through coordinated efforts between the U.S. administration and the industry, preventing the emergence of broader financial instability. However, the underlying problems remain entirely unresolved. In particular, 2026 will see a concentration of CRE refinancing maturities, and as loan-to-value ratios deteriorate, the resulting failures are increasingly likely to surface and become impossible to conceal.

- 景気先行指標である黒人失業率が急上昇中である。The Black unemployment rate, a leading indicator of economic conditions, is rising sharply.

- AI 投資は循環取引を除く実質のROIが7%程度で、莫大な投資に見合った収益を上げることができないため、レバレッジの高いオラクルなどを筆頭に早晩行き詰る予想。The real ROI of AI investments, excluding circular transactions, is only around 7%. Since this level of return cannot justify the massive capital being poured in, highly leveraged companies like Oracle are expected to hit a dead end sooner rather than later.

- 米株のバリュエーションは歴史的高水準にあるU.S. stock valuations remain at historically elevated levels.

- 1930大恐慌からの対数トレンド上値抵抗線にタッチしているThe market is touching the upper resistance line of the logarithmic trend dating back to the Great Depression of the 1930s.

- 米株信用買い残は1兆ドルを超えてきている。逆回転が始まると止まらない。U.S. margin debt now exceeds $1 trillion; once the reversal begins, it may be unstoppable.

- バリュエーション、テクニカルの両面からいつ大暴落となっても不思議はないBoth valuation and technical indicators suggest that a major crash could occur at any time.

- 長短金利差はサームルールに抵触The yield curve inversion violates the Sahm Rule.

- LLMによるAIバブルは2000年ITバブルの様に今だ投資ー収益がクローズしていないThe current AI boom driven by LLMs mirrors the 2000 IT bubble, with investments yet to translate into profits.

- インフレは目標2%より高く、GDPの強さも相まってパウエルは再度利上げするか、利下げを停止するかも。Inflation remains above the 2% target, and with GDP still strong, Powell may either halt rate cuts or even raise rates again.

- 2000年からの上昇は米債務の拡大に支えられており、持続不能なレベルになっているThe post-2000 market rise has been supported by an unsustainable expansion of U.S. debt.

現状、許容額の1/13を保有しているが、下落した場合は、各フィボナッチレベルで1/18ずつ投入する。At present, I hold 1/13 of my target investment amount. Should the market decline, I plan to deploy one-eighteenth of the total at each Fibonacci retracement level.

これからはどこかで梯子を外されることを前提としたチキンレースに突入する。トレンド変換の時には素早くポジションを解消する。ただ、寄り付きで40%下落のように、逃げ切れないほど早く下落した場合は、逆にポジションを1/3追加していきたい。From here, the market enters a game of chicken, assuming that the ladder will be pulled away at some point. Positions must be exited quickly when the trend reverses. However, if a sudden plunge occurs—such as a 40% drop right at the open, leaving no time to escape—I would rather add one-third more to my position.

テクニカル的には1930年からのトレンド上限に達し、また、バフェット指数その他のマクロ指数がバブルであることを示している。トランプの放任財政拡大により風船がさらに膨らむ状態で、なにかを切っ掛けに破裂を待っているのは明らか。On the technical side, the market has reached the upper limit of the trend line dating back to 1930, and macro indicators such as the Buffett Indicator are signaling a bubble. With Trump’s laissez-faire fiscal expansion further inflating the balloon, it is clear that the market is just waiting for some trigger to burst.

ただ、悪いシナリオとして、トランプのFRBへの利下げ要求、放漫財政が、さらなるバブルを引き起こす可能性も否定できない。そうなると、米国の金融風船は更に壊滅的な破裂まで突っ走ることになる。当面は1/3程度のリスクポジションを維持することで、万が一の上昇継続の場合にも対応できる。That said, a worse-case scenario cannot be ruled out: Trump’s pressure on the Fed for rate cuts and his reckless fiscal policies could trigger an even larger bubble. If that happens, the U.S. financial bubble could be headed for an even more devastating collapse. For the time being, maintaining a risk position of around one-third allows for flexibility in the event the market continues to rise unexpectedly.

先週SP500はジリ上げの後ついに上場来高値を更新してしまった。ただ、更新の後は小幅反落している。クリスマスラリーを期待した参加者も多い中、株価は小幅上昇した。クリスマス明けの金曜日にも大きく反落することはなかった。来週からはいよいよ新年に向けたポジションが取られていくと思われる。あらゆる面から株価は天井を示しており、上昇している理由は人々の未来への楽観だけである。いつ下落しても不思議ではないが、企業業績が明確に下落してくる時点まで待たないといけないかもしれない。Last week, the S&P 500 continued its gradual climb and finally reached a new all-time high. However, after breaking that level, it pulled back slightly. While many participants were expecting a Christmas rally, the market posted only modest gains. Even on the Friday after Christmas, there was no significant sell-off. From next week, positioning toward the new year is likely to begin in earnest. From every perspective, equities appear to be signaling a market top, and the only force supporting prices seems to be optimism about the future. A downturn could occur at any time, but it may be necessary to wait until corporate earnings clearly begin to deteriorate.

米金利が下がり、円金利が上がるという金利差縮小が開始したのは明らかで、キャリートレードが今後さらに拡大することはあり得ず、縮小しかない。その事実が相場に反映されるフェイズに入ったということは、日米株安、ドル安トレンドが開始したということに他ならない。It is clear that the narrowing interest rate differential—U.S. rates falling and Japanese rates rising—has begun. Carry trades cannot expand further from here; they can only contract. Entering the phase in which this reality is reflected in market prices effectively means the start of a downtrend in U.S. and Japanese equities and in the dollar.

だが、トレンドは「作られる」。1930年以来のトレンド抵抗線を突破して爆上げしていくならついていくしかないだろう。That said, trends are “made.” If prices break through the trend resistance line that has held since 1930 and surge dramatically, there may be no choice but to follow the move.

プラス面Positive factors

- AIを含め、米株収益はまだ落ち込んできてはいない。Despite concerns, U.S. corporate earnings—including AI-related sectors—have not yet deteriorated.

- UniTreeなど中国ロボットはBostonDynamicsを越えて成長しつつあり、AI、ロボットの爆発的な発展を予想させる。Chinese robotics companies such as Unitree are rapidly advancing and beginning to surpass Boston Dynamics, pointing to an explosive phase of growth in AI and robotics.

- トランプの対中国100%関税は4月と同様TACOである。Trump’s proposed 100% tariff on China appears to be another TACO, as in April.

- GDPは未だ4%近い伸び。GDP growth remains close to 4%.

- パウエルは基本利下げ基調。Powell maintains a general easing bias.

- 過去の短期トレンドからは、まだもうひと上昇ある可能性。Based on past short term trends, another leg up in the market is still possible.

マイナス面Negative factors

- 2025Q3のGDPは4.3%であったが、精度の高いGDPNowの2025年Q4のGDPは3.0%となっており、GDPのピークアウトを示している。U.S. GDP growth in Q3 2025 was 4.3%, but the highly accurate GDPNow estimate for Q4 2025 stands at 3.0%, indicating that GDP growth has peaked.

- 2026年は2025年に引き続き9兆ドルの米国債満期(内4兆ドルは前年度からの短期のロール)となっており、新発債発行による金利上昇が懸念される。2026, following on from 2025, will see approximately $9 trillion in U.S. Treasury maturities, of which $4 trillion are short-term rollovers from the previous year, raising concerns that new debt issuance will push interest rates higher.

- CRE崩壊は米政権業界一体の隠ぺいによって金融不安の発生を防いでおり、内包された問題は全く解決されていない。特に2026年はCRE借換満期が集中しており、LTVの悪化による破綻が隠しきれずに顕在化する可能性が大きい。The collapse of the commercial real estate (CRE) sector has so far been concealed through coordinated efforts between the U.S. administration and the industry, preventing the emergence of broader financial instability. However, the underlying problems remain entirely unresolved. In particular, 2026 will see a concentration of CRE refinancing maturities, and as loan-to-value ratios deteriorate, the resulting failures are increasingly likely to surface and become impossible to conceal.

- 景気先行指標である黒人失業率が急上昇中である。The Black unemployment rate, a leading indicator of economic conditions, is rising sharply.

- AI 投資は循環取引を除く実質のROIが7%程度で、莫大な投資に見合った収益を上げることができないため、レバレッジの高いオラクルなどを筆頭に早晩行き詰る予想。The real ROI of AI investments, excluding circular transactions, is only around 7%. Since this level of return cannot justify the massive capital being poured in, highly leveraged companies like Oracle are expected to hit a dead end sooner rather than later.

- 米株のバリュエーションは歴史的高水準にあるU.S. stock valuations remain at historically elevated levels.

- 1930大恐慌からの対数トレンド上値抵抗線にタッチしているThe market is touching the upper resistance line of the logarithmic trend dating back to the Great Depression of the 1930s.

- 米株信用買い残は1兆ドルを超えてきている。逆回転が始まると止まらない。U.S. margin debt now exceeds $1 trillion; once the reversal begins, it may be unstoppable.

- バリュエーション、テクニカルの両面からいつ大暴落となっても不思議はないBoth valuation and technical indicators suggest that a major crash could occur at any time.

- 長短金利差はサームルールに抵触The yield curve inversion violates the Sahm Rule.

- LLMによるAIバブルは2000年ITバブルの様に今だ投資ー収益がクローズしていないThe current AI boom driven by LLMs mirrors the 2000 IT bubble, with investments yet to translate into profits.

- インフレは目標2%より高く、GDPの強さも相まってパウエルは再度利上げするか、利下げを停止するかも。Inflation remains above the 2% target, and with GDP still strong, Powell may either halt rate cuts or even raise rates again.

- 2000年からの上昇は米債務の拡大に支えられており、持続不能なレベルになっているThe post-2000 market rise has been supported by an unsustainable expansion of U.S. debt.

現状、許容額の1/13を保有しているが、下落した場合は、各フィボナッチレベルで1/18ずつ投入する。At present, I hold 1/13 of my target investment amount. Should the market decline, I plan to deploy one-eighteenth of the total at each Fibonacci retracement level.

これからはどこかで梯子を外されることを前提としたチキンレースに突入する。トレンド変換の時には素早くポジションを解消する。ただ、寄り付きで40%下落のように、逃げ切れないほど早く下落した場合は、逆にポジションを1/3追加していきたい。From here, the market enters a game of chicken, assuming that the ladder will be pulled away at some point. Positions must be exited quickly when the trend reverses. However, if a sudden plunge occurs—such as a 40% drop right at the open, leaving no time to escape—I would rather add one-third more to my position.

テクニカル的には1930年からのトレンド上限に達し、また、バフェット指数その他のマクロ指数がバブルであることを示している。トランプの放任財政拡大により風船がさらに膨らむ状態で、なにかを切っ掛けに破裂を待っているのは明らか。On the technical side, the market has reached the upper limit of the trend line dating back to 1930, and macro indicators such as the Buffett Indicator are signaling a bubble. With Trump’s laissez-faire fiscal expansion further inflating the balloon, it is clear that the market is just waiting for some trigger to burst.

ただ、悪いシナリオとして、トランプのFRBへの利下げ要求、放漫財政が、さらなるバブルを引き起こす可能性も否定できない。そうなると、米国の金融風船は更に壊滅的な破裂まで突っ走ることになる。当面は1/3程度のリスクポジションを維持することで、万が一の上昇継続の場合にも対応できる。That said, a worse-case scenario cannot be ruled out: Trump’s pressure on the Fed for rate cuts and his reckless fiscal policies could trigger an even larger bubble. If that happens, the U.S. financial bubble could be headed for an even more devastating collapse. For the time being, maintaining a risk position of around one-third allows for flexibility in the event the market continues to rise unexpectedly.

トランプの新規政策、戦争など、突発的な暴落に対応するため、今後組み入れても、追加1/3程度で、総組み入れは最大2/3程度。To prepare for sudden market crashes triggered by new Trump policies or potential wars, even if I do resume buying, I plan to limit additional investments to about one-third, with total exposure capped at a maximum of two-thirds.

トランプの新規政策、戦争など、突発的な暴落に対応するため、今後組み入れても、追加1/3程度で、総組み入れは最大2/3程度。To prepare for sudden market crashes triggered by new Trump policies or potential wars, even if I do resume buying, I plan to limit additional investments to about one-third, with total exposure capped at a maximum of two-thirds.

IMMは円買いに転換。IMM switched back to JPY buy.

新値日足は下落。AI予測は日足が下落。週足が上昇。月足は下落。The new daily candlestick is down. AI predictions indicate the daily candlestick will decline, the weekly candlestick will rise, and the monthly candlestick will decline.

メガバンクの上昇は利上げの効果というより、バリュー株の底上げという性格が強い。メガバンクはことごとく一律に上昇してきた。爆上げしたのはメガバンクだけでなく、建設、重工業など、割安に放置されてきたセクターだ。ただ、このまま上がり続けるには無理があり、どこかでメガバンクのように一旦頭を打つだろう。The rise in mega-banks is characterized more by the uplift of value stocks than the effect of interest rate hikes. Mega-banks have uniformly risen, as have sectors such as construction and heavy industries, which have been undervalued. However, it's unlikely that they will continue to rise indefinitely, and at some point, they are likely to experience a downturn, similar to mega-banks.

米株は、リモートワーク定着による商業用不動産の暴落が、いまだ株式市場に織り込まれていないのが最大の懸念材料。The crash of US commercial real estate due to the establishment of remote work has not yet been factored into the stock market.

根底には中国の不動産崩壊もある。中国マネーの縮小が、世界の商業用不動産の下落に拍車をかける。The underlying factor is also the collapse of Chinese real estate. The reduction of Chinese money will further accelerate the decline of commercial real estate worldwide.

米貸し出し延滞率もコロナ支援金の枯渇に伴い急速に上昇しつつある。The delinquency rate for US lending is also rapidly increasing due to the depletion of COVID relief funds.

米株の急落とともに世界株式が暴落するのも、ここ数カ月以内に起こるだろう。The crash of US stocks will likely lead to a global stock market crash within the next few months.

現状日銀は700兆円近くの国債を買い入れており、これは国債発行残高の6割近く。このうち6兆円が毎月満期になるため、月額6兆円を買い入れている。このため、月額買入を3兆円に減額すると1年間に36兆円のQTとなる。全保有額を放出するには20年近くかかるため、それまでは廃止したと言いながら継続しているYCCが続くことになる。これが国債が売られた背景。 Currently, the Bank of Japan holds nearly 700 trillion yen in government bonds, which is close to 60% of the total government bond issuance. Of this amount, 6 trillion yen matures every month, leading the BOJ to purchase 6 trillion yen monthly. Therefore, reducing the monthly purchases to 3 trillion yen results in a QT of 36 trillion yen annually. It would take nearly 20 years to completely unwind their holdings, so despite announcing the end of yield curve control (YCC), it effectively continues. This is why government bonds are being sold off.

米株は、リモートワーク定着による商業用不動産の暴落が、いまだ株式市場に織り込まれていないのが最大の懸念材料。The crash of US commercial real estate due to the establishment of remote work has not yet been factored into the stock market.

根底には中国の不動産崩壊もある。中国マネーの縮小が、世界の商業用不動産の下落に拍車をかける。The underlying factor is also the collapse of Chinese real estate. The reduction of Chinese money will further accelerate the decline of commercial real estate worldwide.

米貸し出し延滞率もコロナ支援金の枯渇に伴い急速に上昇しつつある。The delinquency rate for US lending is also rapidly increasing due to the depletion of COVID relief funds.

米株の急落とともに世界株式が暴落するのも、ここ数カ月以内に起こるだろう。The crash of US stocks will likely lead to a global stock market crash within the next few months.

PSAVEは若干持ち直し基調。ドル円は介入開始か。PSAVE shows a slight recovery trend. Could intervention begin with the USD/JPY pair?

長谷工は下落トレンドから復帰。Haseko showed exit from down-trend.

米銀株、USTU10とSPX, NKY US Banks, UST10&SPX, NKY

米国株はサームルール発動により景気後退入りが確実となった。

今後のシナリオとしては、最初の利下げまでは株価は上昇、最初の利下げを境に下落開始となるシナリオ。The upcoming scenario is that stock prices will continue to rise until the first rate cut, after which they will start to decline.

中国株は反発するも未だ復活していない。不動産不況から始まるバブル崩壊はまだ始まったばかりかもしれない。Chinese stocks have rebounded but have yet to recover. The bursting of the bubble, starting with the real estate recession, might have only just begun.

NY株は景気後退のシグナルが其処ここに出ているのを無視して、パウエルの利下げとM7のみの好況を理由に上昇しているが、これがいつまでも続くわけはない。Despite various signs of an economic downturn, NY stocks are rising, driven by Powell's interest rate cuts and the strong performance of the M7 companies. However, this cannot continue indefinitely.

VIXは上昇。Vix has gone up.

中国株は反発するも未だ復活していない。不動産不況から始まるバブル崩壊はまだ始まったばかりかもしれない。Chinese stocks have rebounded but have yet to recover. The bursting of the bubble, starting with the real estate recession, might have only just begun.

NY株は景気後退のシグナルが其処ここに出ているのを無視して、パウエルの利下げとM7のみの好況を理由に上昇しているが、これがいつまでも続くわけはない。Despite various signs of an economic downturn, NY stocks are rising, driven by Powell's interest rate cuts and the strong performance of the M7 companies. However, this cannot continue indefinitely.

VIXは上昇。Vix has gone up.

米金利の今後 US FF rate forecast

米インフレの鎮静化は一時停止状態で、失業率は低下し、景気はまだ強く、インフレ圧力の復活の可能性も秘めているように見える。これがパウエルが利下げを早期に行えない原因。The pacification of US inflation remains suspended, and with a decrease in the unemployment rate and continued strong economy, there seems to be a possibility of a resurgence of inflation pressure. This is the reason why Powell cannot cut interest rates early.